Las máquinas no piensan, eso es una ilusión. No lo decimos, un grupo de investigadores de Apple que acaban de publicar un estudio revelador titulado Precisely (‘La ilusión del pensamiento‘). En él, estos expertos han analizado el rendimiento de varios modelos de IA con la capacidad de «razonar», y sus conclusiones son sorprendentes … y preocupantes.

Rompecabezas por la «razón». Lo normal al evaluar la capacidad de un modelo de IA es usar puntos de referencia con programas o pruebas de matemáticas, por ejemplo. En cambio, Apple creó varias pruebas basadas en rompecabezas lógicos que eran totalmente nuevos y, por lo tanto, no podían ser parte del entrenamiento de estos modelos. Claude Thinking, Deepseek-R1 y O3-Mini participaron en la evaluación.

Modelos que se bloquean. En sus pruebas Ellos revisaron Como todos estos modelos de razonamiento, terminaron protagonizando bruces contra una pared cuando enfrentaron problemas complejos. En esos casos, la precisión de estos modelos recurrió al 0%. Tampoco se igualó que otorgó más recursos a estos modelos al tratar de resolver esos problemas. Si fueran de alguna dificultad, no pudieron con ellos.

Se cansan de pensar. De hecho, sucedió algo curioso. A medida que los problemas se volvieron más complicados, estos modelos comenzaron a pensar más, pero menos. Usaron menos tokens para resolverlos y plagar antes de poder usar recursos ilimitados.

No con ayuda. Los investigadores de Apple incluso intentaron dar a los modelos un algoritmo exacto que guió a los modelos para encontrar el paso a paso. Y aquí, otra sorpresa de capital: ninguno de los modelos logró resolver problemas a pesar de tener esas soluciones guiadas. No pudieron seguir las instrucciones de manera consistente.

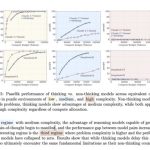

Estos gráficos muestran las diferencias entre los modelos que no razonan (Deepseek-V3) con aquellos que lo hacen (Deepseek-R1) en problemas de baja complejidad (amarillo), medio (azul) y alto (rojo). Solo hay ventajas para el «razonamiento» en problemas de dificultad media. En los modelos altos simplemente colapsan. Fuente: Apple.

Tres tipos de problemas. En su evaluación, dividieron los problemas que se resolverán en tres clases y verificaron si los modelos de razonamiento realmente contribuyeron algo a los modelos tradicionales que no «razonan».

- Problemas de baja complejidad: los modelos de razonamiento superaron efectivamente a aquellos que no tenían esa capacidad de razonamiento. Por supuesto, a menudo piensan demasiado para resolver estos problemas simples.

- Problemas promedio de complejidad: todavía había alguna ventaja sobre los modelos convencionales, pero no demasiado.

- Problemas de alta complejidad: todos los modelos terminaron protagonizando estos problemas.

Pensando, nada. Según estos investigadores, la razón de esta falla al razonar en problemas complejos es simple. Estos modelos no «razonan» en absoluto, y todo lo que hacen es usar técnicas de reconocimiento de patrones avanzados para resolver problemas. Eso no funciona con problemas complejos, y allí los cimientos de estos modelos se están desmoronando por completo. Dados estos problemas, si un modelo recibe instrucciones claras y más recursos deberían mejorar y poder tratar de resolverlos, pero este estudio demuestra lo contrario.

Lejos de agi. Lo que estos resultados sugieren es que la expectativa que estos modelos han generado no se merecen: los modelos de razonamiento actuales simplemente no logran pasar de una cierta barrera agregando datos o computación. Algunos señalaron cómo los modelos de razonamiento podrían ser una forma posible para la búsqueda de AGI, pero las conclusiones de este estudio revelan que, de hecho, no estamos más cerca de lograr modelos que puedan considerarse inteligencia artificial general.

No encuentran soluciones, las memorizan y las copian. De hecho, el estudio corroboró algo que otros defendieron en el pasado: estos modelos simplemente tienen conocimiento y reproducen la solución que ya habían memorizado cuando encuentran los patrones correspondientes que conducen a esa solución. Por lo tanto, estos modelos podrían resolver el famoso problema del Torres de hanoi De muchos movimientos porque una vez saben que la solución se puede aplicar sistemáticamente. Sin embargo, en otros rompecabezas fallaron en los pocos movimientos.

Loros estocásticos. Muchos de los críticos de la IA siempre Ellos han defendido Que los modelos generativos, razón o no, son básicamente loros que repiten lo que se ha enseñado. En el caso de la IA, detectan patrones y pueden encontrar/predecir la siguiente palabra/píxel al generar texto o imágenes. El resultado suele ser convincente, pero solo porque se han vuelto extremadamente buenos al detectar estos patrones y responder de manera adecuada y coherente. Pero no es un conocimiento nuevo: es repetir la quya.

Ellos no piensan. Otros expertos críticos de estas expectativas nos han alertado de que nos alertaran sobre los peligros del antropomorfismo de la IAS. Lo expliqué Subbarao Kambhamppti, de la Universidad de Arizona, que, por ejemplo, analizó el proceso de «razonamiento» de estos modelos y su «cadena de pensamiento». Usamos verbos como «pensar», cuando no piensan. No entienden lo que hacen, y eso contamina todos los supuestos que hacemos sobre su capacidad (o falta de ella).

No confíes en lo que te dice la IA. El comportamiento de estos modelos confirma lo que se sabe desde que ChatGPT apareció en la escena. Tan convincente de que estos modelos pueden parecer, «razón» o no, la realidad es que pueden cometer errores graves y cometer errores, aunque otros ciertamente correctamente. De hecho, hay casos en los que estos modelos sorprenden por su capacidad para resolver problemas: En Scientific American Un grupo de matemáticos fue superado por un modelo de IA que logró resolver algunos de los problemas matemáticos más complejos que no pudieron resolver, o que tardaron más en resolver.

Imagen | Rompecabezas

En | Copilot, ChatGPT y GPT-4 han cambiado el mundo de la programación para siempre. Esto se piensa en programadores